"Happy (first) Birthday ChatGPT!" - große Sprachmodelle und das Große Geld

ChatGPT hat als bekanntester Vertreter der sogenannten Generativen KI, also der KI, die "etwas Neues" generiert, die öffentliche Diskussion rund um KI ganz allgemein geprägt.

Manche sehen darin den "iPhone-Moment der KI" und meinen damit den Beginn einer disruptiven, revolutionären Umgestaltung unserer gesamten Lebens- und Arbeitswelt durch KI.

Tatsächlich sind die potentiellen Implikationen sehr weitreichend und noch gar nicht abschätzbar. So wird im Schulwesen und der universitären Ausbildung diskutiert, wie mit der Benutzung von Systemen wie ChatGPT praktisch umzugehen ist: Lässt man die Benutzung uneingeschränkt zu und erlaubt den Lernenden ganze Aufsätze und Projektaufgaben damit zu bewältigen oder geht man sehr restriktiv damit um und verbietet gar deren Einsatz? Hier gilt es noch einen sinnvollen Kompromiss zu finden.

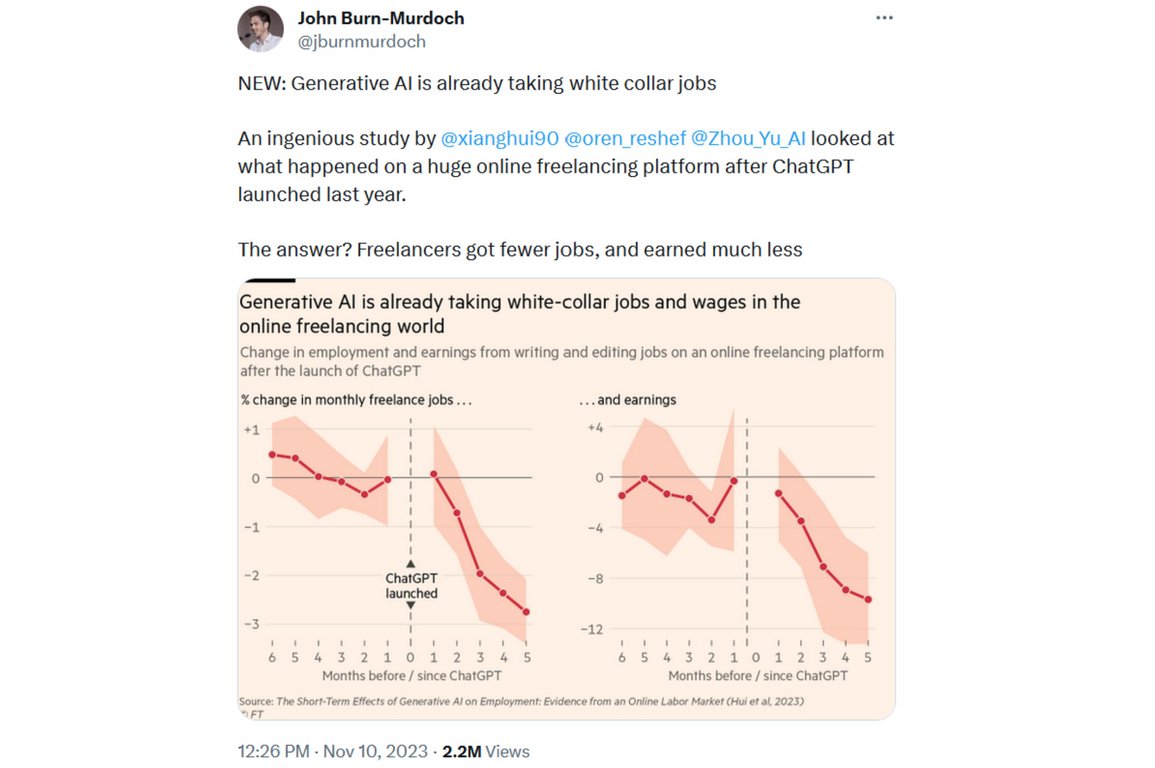

Für die Arbeitswelt stellen sich unter anderem Fragen zum Copyright bei der Verwendung von generierten Inhalten, wie generiertem Programmcode oder kreativem Material für beispielsweise Marketing-Kampagnen, sowie auch ganz prinzipielle Fragen zum Aussehen des Arbeitsmarktes von morgen. Erstmals scheinen auch die auf Ausbildung und Wissen basierenden qualifizierten Jobs von Rationalisierung bedroht zu sein, wie erste Untersuchungen und Veröffentlichungen dazu nahelegen - siehe auch den folgenden Tweet, in dem die Umsatz- und Gewinneinbrüche bei einer Freelancer-Plattform bereits zu erkennen sind [^1].

Die "OpenAI-Saga" oder der Stoff aus dem Filme sind

Ein weiteres klares Indiz für die umfangreiche Bedeutung, das große ökonomische Potential, sowie die Kontroverse der Technologie konnte man dieser Tage an dem Krimi um den Mitgründer und CEO von OpenAI Sam Altman sehen, mit dem OpenAI die erstaunte Öffentlichkeit überraschte. Als Auftakt verlangt der Chief-Scientist eine Sitzung des Verwaltungsrates, infolge dieser, nur einen Tag später der CEO aufgrund von "mangelnder Transparenz" vom Verwaltungsrat entlassen wird. Die neue ernannte Interims-CEO Mira Murati sucht sofort nach Wegen den alten CEO wieder einzustellen. Danach legt sie ihr Amt nieder und unterschreibt zusammen mit dem ursprünglich ausschlagebenden Chief-Scientist die Forderung, dass der Verwaltungsrat zurücktreten und Sam Altman wieder einsetzten soll. Insgesamt unterschreiben 700 von 750 Angestellten bei OpenAI diese Forderung und kündigen an, ansonsten mit dem alten CEO zu gehen.

Unterdessen macht Microsoft, das bereits ca. 13 Mrd. Dollar in die Partnerschaft mit OpenAI investiert hat, Sam Altman ein sehr gutes Angebot. Gleichzeitig erneuert Microsoft sein Bekenntnis zu OpenAI. Mit anderen Kunden und Investoren von OpenAI bestürmt Microsoft den Verwaltungsrat, den vorherigen Zustand wieder herzustellen und Sam Altmann wieder einzusetzen. Am Ende beugt sich schließlich der Verwaltungsrat dem großen Ansturm, tritt zurück, formiert sich neu und stellt Sam Altman als CEO wieder an. Der kurzzeitig zwischendurch als weiterer Iterims-CEO fungierende Emmet Shear war damit nur ganze rekord-verdächtige 55 Stunden und 32 Minuten CEO von OpenAI. Was diese turbulente "Geburtstagsparty" von ChatGPT sehr besonders macht ist, dass der Grund für die Entlassung bis heute im Dunkeln liegt. Lediglich eine Mitteilung wirft einen vermeintlichen Durchbruch in Richtung AGI, der Artificial General Intelligence - also der Künstlichen Allgemeinen Intelligenz und damit dem heiligen Gral der KI, in den Raum. Unter AGI versteht man eine Intelligenz, die nicht auf einen bestimmten engen Bereich beschränkt ist, sondern in seiner Breite und Allgemeinheit der menschlichen Intelligenz mindestens ebenbürtig oder sogar überlegen ist. Ein großes Netz genannt Q* soll in der Lage gewesen sein anspruchsvolle mathematische Probleme zu lösen, was die Kontroverse ausgelöst haben soll, wie genau man mit so einem bedeutenden Durchbruch verantwortungsvoll umgehen sollte. Man könnte diese Technologie schnell in Produkte gießen oder doch erst einmal auf Sicherheit und Vorsicht setzen. Allerdings beflügeln diese beiden Symbole Q* jetzt die Phantasie einer ganze Branche von ansonsten nüchternen, faktenbasiert vorgehenden Menschen zu wilden Spekulationen. Man kann das schon getrost als Kaffesatzleserei bezeichnen, was alles versucht wird aus Q* über die genau genutzte Technologie des Durchbruchs herauszulesen. Wo wir noch nicht einmal wissen, ob es überhaupt wirklich solch einen Durchbruch gab. Wer die ganze Geschichte in ihrer Einzelheit noch einmal nachverfolgen möchte sei auf [^2] verwiesen, sowie die zwei dazugehörigen, vorhergehenden Folgen und wer weiß, vielleicht kann man die ganze Geschichte irgendwann in einer Doku bei Netflix und Co. bestaunen.

Die Technologie hinter ChatGPT - Large Language Models (LLMs)

Transformer

Doch zurück aus der Welt der Spekulationen, des großen Geldes und der großen Gefahren. Was steckt eigentlich technisch hinter ChatGPT? Wofür stehen die Buchstaben GPT? GPT steht für Generative Pretrained Transformer, auf Deutsch also für einen "vortrainierten, generierenden Transformer". Transformer haben nichts mit den sich von und in Autos verwandelnden Robotern der Transformer-Filme zu tun, sie stellen eine Architektur großer künstliche Neuronale Netze dar. Ende 2017 wurde diese Architektur erstmals im Zusammenhang mit der automatischen Übersetzung von Texten, also der Transformation von der einen Sprache in die andere, veröffentlicht[^3] und trat ihren Siegeszug in alle Anwendungsgebiete der KI an.

![Adaptiert von [^3] Schaubild](/fileadmin/_processed_/f/6/csm_2023-12-14_Zfki-Blog_ChatGPT_3_Transformer_encoder_e67324a9aa.jpg)

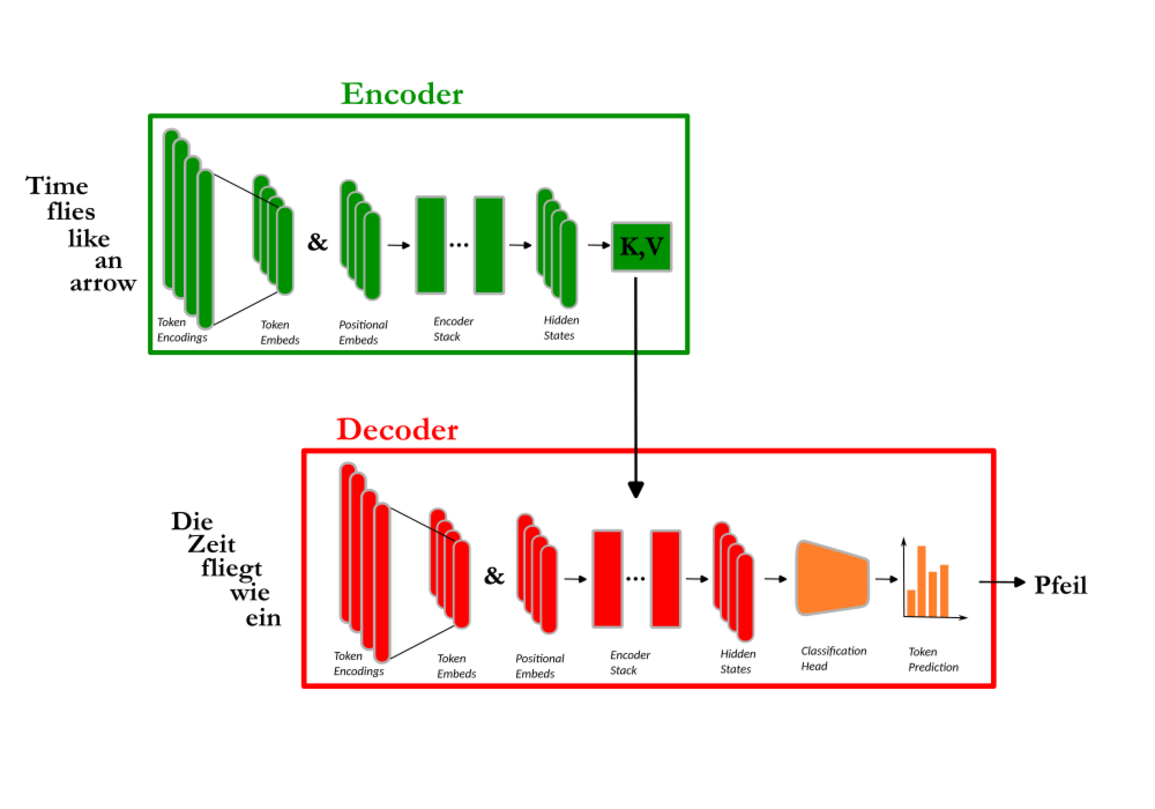

Im Wesentlichen besteht der Transformer in seiner ursprünglichen Form aus zwei Teilen einem Encoder und einem Decoder.

Betrachtet wir den Transformer bei seiner ganz ursprünglichen Anwendung, dem Übersetzen von Text:

Der englische Satz wird in seine einzelnen Bestandteile, Worte und Satzzeichen - sogenannte Tokens, zerlegt und diese dann in Zahlen bzw. Vektoren kodiert. Neuronale Netze können nur mit Zahlen umgehen, brauchen deshalb Zahlen bzw. Vektoren am Eingang und liefern auch nur Zahlen bzw. Vektoren an ihrem Ausgang, die dann wieder in Text übersetzt werden müssen. Der Encoder übersetzt den Text bzw. die Vektoren für einzelne Worte in eine interne Repräsentation des Netzes in einem mehrdimensionalen Vektorraum. So wird beispielsweise das Konzept für "arrow" in einem bestimmten Punkt bzw. Teil dieses Vektorraumes abgebildet oder besser repräsentiert. Diese Repräsentation wird dann an den Decoder weitergereicht, der mit der zusätzlichen Hilfe seiner eigenen vorhergehenden deutschen Ausgabe das interne Konzept für "arrow" mit hoher Wahrscheinlichkeit dem deutschen Wort "Pfeil" zuordnen kann. Ein wesentlicher Punkt für den Erfolg der Transformer, im Unterschied zu vorherigen Ansätzen von Neuronalen Netzen, ist die Nutzung eines flexiblen breiteren Kontextes, den man für Sprache braucht. Oft liegt ein Wort, das am wichtigsten ist, weiter zurück in der Vergangenheit und nicht direkt vor dem aktuell betrachteten Wort. So ist z.B. im Satz "Das Bild, das mir im vorherigen Raum so gefallen hat, war das große." der Anfang "Das Bild" der wichtigste Kontext für das letzte Wort "große" des Satzes. D.h. will man das letzte Wort des Satzes vorhersagen, so muss man "den größten Teil der Aufmerksamkeit" auf den Anfang des Satzes legen und nicht auf die direkt vorhergehenden Wörter. Folgerichtig nennt man dieses Konzept auch Attention . Der Transformer in seinem vollen Ausbau mit Encoder und Decoder hat gleich mehr davon. Einerseits jeweils eine Self-Attention für die Eingabe im Encoder und Decoder und andererseits eine Cross-Attention für den Kontext von Decoder zu Encoder - also von einer Sprache zur anderen in unserem Beispiel.

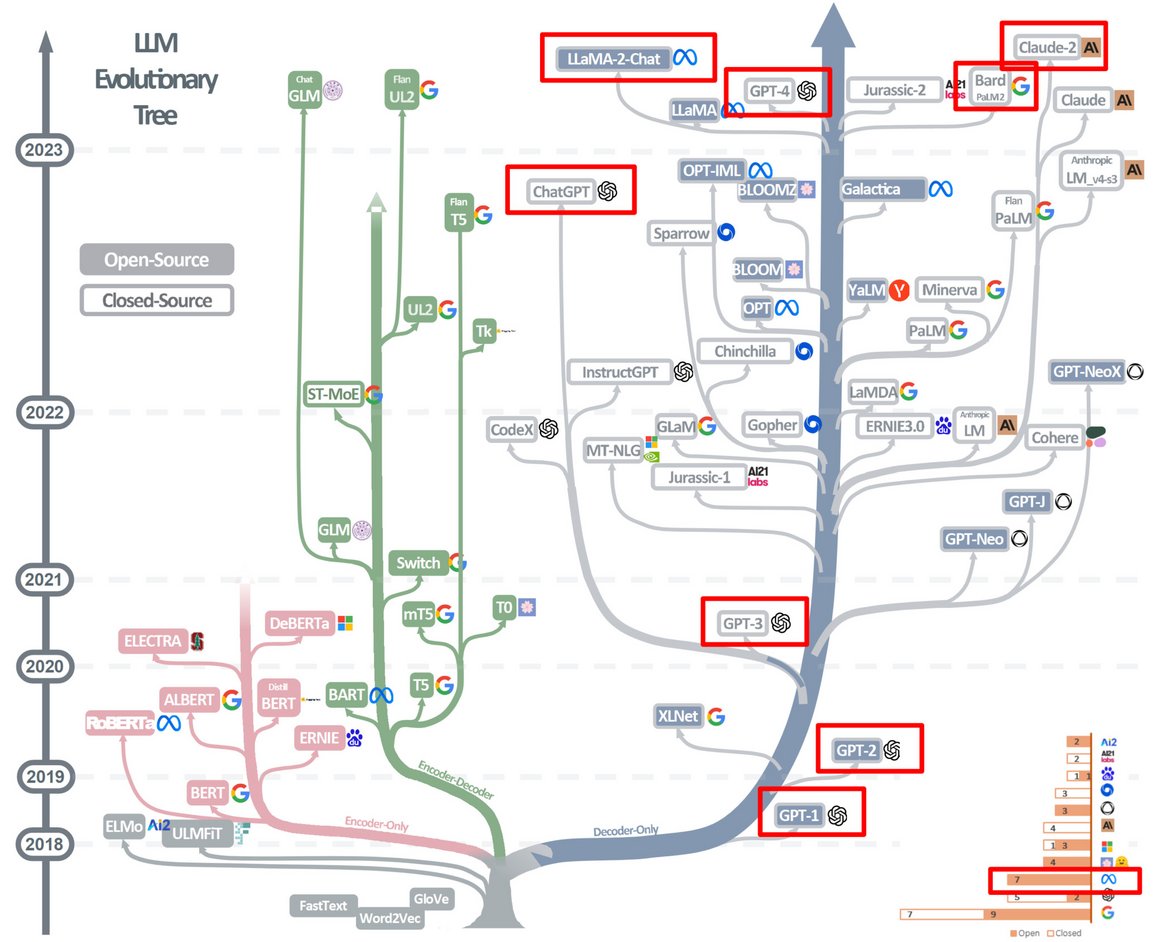

Es zeigt sich auch, dass nicht nur das Zusammenspiel von Decoder und Encoder sinnvoll ist, sondern auch reine Encoder-Netze und reine Decoder-Netze ihren Sinn haben, womit sich die Familie der Transformer in drei Stämme aufteilen lässt - siehe Bild [Stammbaum der LLMs → LLM-Baum.png]. Schaut man sich beispielsweise den Decoder im Bild [Ein Transformer beim Übersetzen von Englisch nach Deutsch → Transformer_Seq2Seq.svg] genau an und "verzichtet auf die Hilfe des Encoders", kann man so ungefähr schon die gewohnte Arbeitsweise mit ChatGPT erkennen. "Die Zeit fliegt wie ein" könnte man bereits als sogenannten Prompt bezeichnen, der die Antwort "Pfeil" des Decoders als Fortsetzung des Prompts generiert. Nimmt man den Rahmen für den Kontext etwas größer, auf mehrere Sätze oder Abschnitte ist es das, was ChatGPT tut.

Alle großen Sprachnetze von OpenAI, Google, Meta-AI, Anthropic und dem deutschen Hoffnungsträger Aleph Alpha basieren im Kern auf Abwandlungen dieser drei Architekturen. Damit trafen in den letzten Jahren, die drei notwendigen Zutaten für den Erfolg großer Sprachmodelle zusammen:

- Die Verfügbarkeit großer Datenmenge aus dem Internet, um die großen komplexen Netze zu trainieren,

- Die Transformer als die passende Architektur, sowie

- Die notwendige Rechenkraft durch die Entwicklung leistungsfähiger Grafik-Prozessoren (GPUs) und Spezialprozessoren (TPUs) um das aufwendige Training der Netze in vertretbarer Zeit zu absolvieren.

Das Training solcher großen Netze ist sehr aufwendig und rechenintensiv, so dass diese Arbeit nur sehr große Firmen mit Rückgriff auf genügend große Rechnerinfrastruktur stemmen können. Hier sind als Beispiel die verfügbaren Angaben für GPT-3, dessen etwas weiterentwickelte Version GPT-3.5 Grundlage für das frei verfügbare ChatGPT ist und das einzige als Open-Source verfügbare Modell LLaMA-2 von Meta-AI zusammengetragen:

Zur Einordnung: 1 Billion Token ~ 1 Mill. Romane ~ 1 Mrd. Zeitungsartikel

Die Netze lernen aus ihren Trainingsdaten ein grundsätzliches Sprach"verständnis", also Aufbau, Grammatik, etc. Dies gilt allerdings nur im statistischen Sinne. Sie "verstehen" nicht wirklich Sprache, so wie wir damit umgehen. So wie oben in der Darstellung zur Übersetzung angedeutet, nimmt das Netz die wahrscheinlichste Fortsetzung von "Die Zeit fliegt wie ein ..." und die ist "Pfeil" und nur mit geringerer Wahrscheinlichkeit "Vogel", "Fliege", etc.

Um sich den Unterschied zu verdeutlichen, kann man einen einfachen und eindrucksvollen Test machen. Fragen Sie doch mal ChatGPT nach einem Elternteil einer berühmten Persönlichkeit und dann gleich anschließend nach der Tochter oder dem Sohn dieses Elternteiles. Je nach Würdigung des verwandtschaftlichen Verhältnisses im Internet ist ChatGPT zwar in der Lage das Elternteil zu benennen, aber danach nicht das Kind, von dem wir gerade nach dem Elternteil gefragt hatten. Dies ist eine für einen Menschen einfache Aufgabe, der die zweite Frage auf alle Fälle beantworten kann, wenn er in der Lage ist, die erste Frage zu beantworten. Ein weiterer Nachteil sind die sogenannten Halluzinationen von LLMs, d.h. LLMs können Fakten einfach erfinden, die meist recht plausibel klingen und damit nicht so leicht als falsch zu entdecken sind.

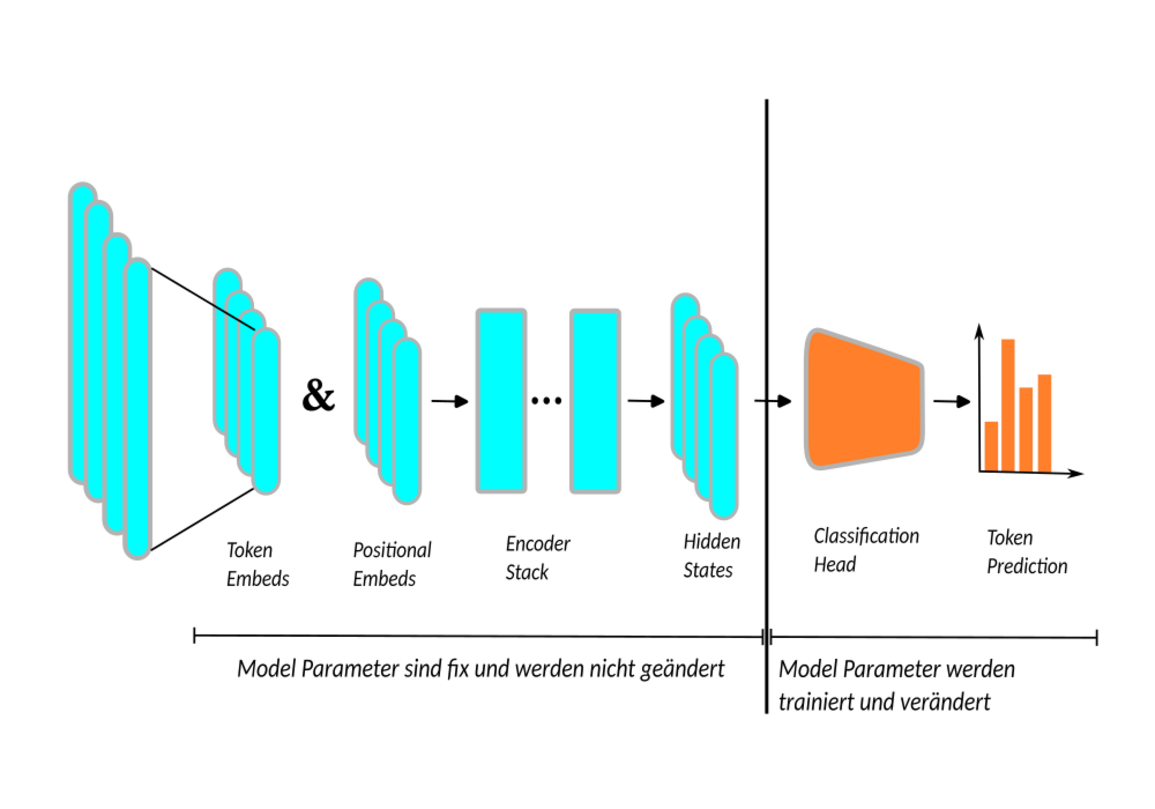

Um nicht für jede neue Aufgabe und für jeden neuen Anwendungsbereich, wie z.B. Chat-Bots, Bildgeneratoren, etc., ein komplettes großes Netz neu trainieren zu müssen, geht man in einem gemischten Ansatz vor. Man nimmt ein bereits vortrainiertes LLM, das ein allgemeines Sprachverständnis aufweist, und kombiniert es mit einem kleineren Netz als Aufsatz, dem sogenannten Head, der dann für den entsprechend Einsatzzweck trainiert wird:

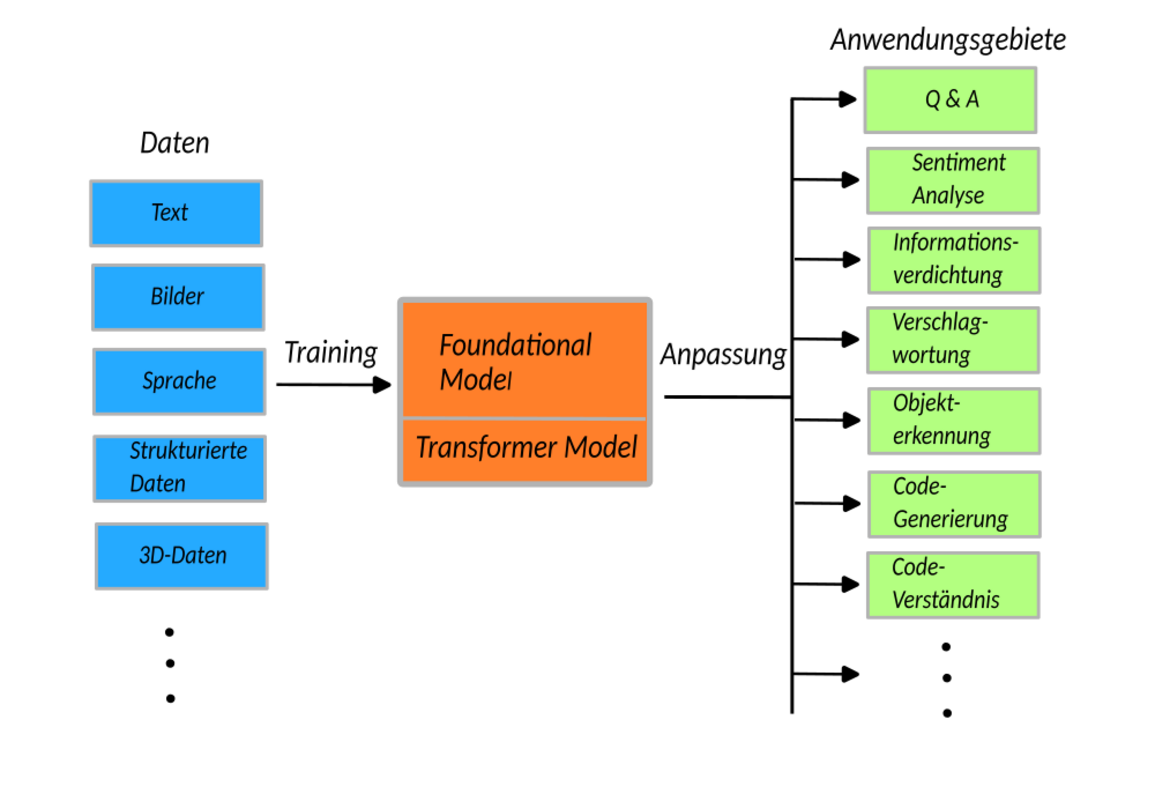

Ausgehend von einem solchen großen, vortrainierten Foundation Model's kann man dann kostengünstiger und energiesparender mit weniger Aufwand ein Netz für seine Anwendungsbereiche trainieren:

Gerade das frei verfügbare Netz LLaMA-2 von Meta-AI wird deshalb gern als Ausgangspunkt für eigene Versuche und Ansätze genommen, sowohl im akademischen wie auch im betrieblichen Umfeld. Auch im Firmenkontext gibt es eine ganze Reihe von Stellen an denen ein eigenes LLM nützlich wäre. So wäre es schön, ein internes "ChatGPT" zu haben, das die gesammelte Wissensbasis der Firma so einfach und niederschwellig zugänglich macht, wie es ChatGPT tut und es dabei nicht nötig macht, dieses Wissen vorher dafür einer weiteren Partei wie OpenAI zugänglich machen zu müssen.

OpenAI - von Open zu Closed AI

Blicken wir zurück auf die Geschichte von OpenAI, das einst von Elon Musk, Sam Altman und Co. als NonProfit-Organisation gegründet wurde. Das Ziel war, dass eine leistungsstarke KI nicht allein den großen und reichen Unternehmen vorbehalten bleibt und es auch eine für die Allgemeinheit zugängliche, quelloffene, leistungsfähige KI gibt.

Dieser grundlegende Kurs hat sich beim Übergang von GPT-2 nach GPT-3 grundlegend geändert. Heute tritt immer mehr der kommerzielle Aspekt und die Vermarktung bei OpenAI zu tage. Interessant ist auch, wenn man sich den Stammbaum der LLM's in der Abbildung ansieht, dass das einzige, quelloffene und freiverfügbare LLM LLaMA-2 ausgerechnet von Meta-AI kommt. Das ist die KISparte des früheren Facebook-Konzerns ( jetzt Meta), der eigentlich nicht gerade das Image von Transparenz und Offenheit hatte. Schaut man sich die Abbildung noch etwas genauer an, dann fällt auf, dass sogar alle Sprachmodelle von Meta-AI offen sind. Das ist im Wesentlichen wohl ein Verdienst des Chief-Scientists von Meta-AI Yann Lecun, der einer der drei Turing-Award-Gewinner für das Deep Learning und zugleich eine starke Stimme für Transparenz, Offenheit, Forschungsfreiheit und Gelassenheit in der temperamentvoll diskutierten Kontroverse um KI ist.

Auf der anderen Seite steht beispielsweise Geoffrey Hinton, ein weiterer der drei Turing-Award-Gewinner und "die graue Eminenz der Neuronalen Netze", der im Angesicht des rasanten Fortschritts des Fachgebietes in das Lager gewechselt ist, das vorsichtiger und langsamer vorgehen möchte und dafür dann aber auch mehr Intransparenz in Kauf nimmt.

Ausblick auf die Zukunft

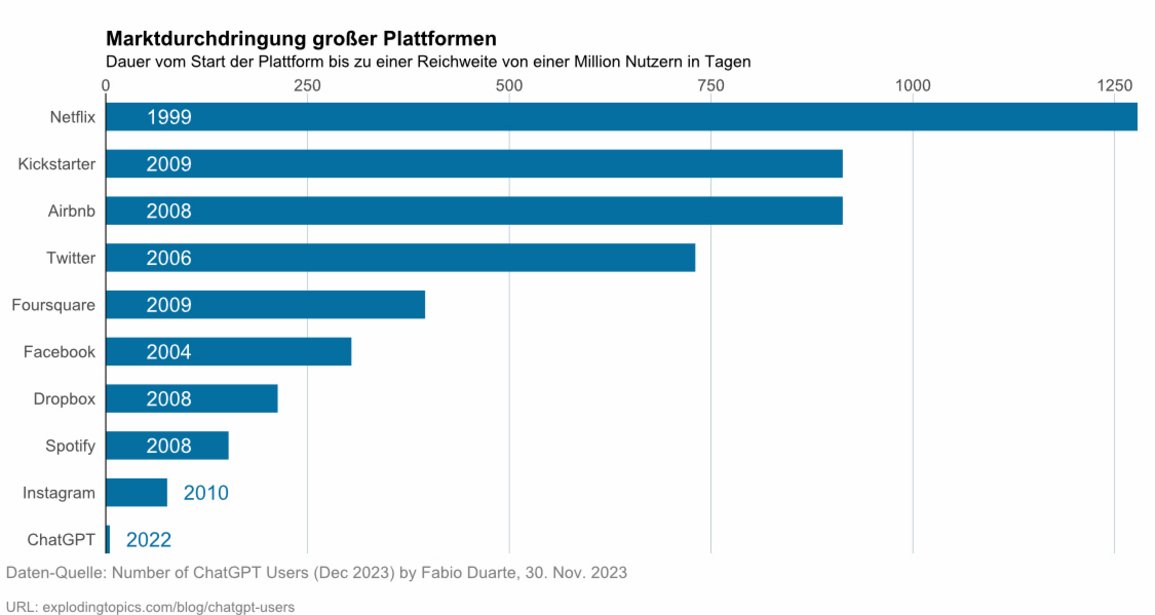

Am Ende eines Jahres ist es immer Zeit für einen Ausblick auf das neue Jahr und die Zukunft. Was haben wir zu erwarten? Einen Eindruck dazu bekommt man bereits, wenn man lediglich auf die Beschleunigung der technologischen Entwicklung schaut. Nimmt man als einen Gradmesser dafür die Zeit, die eine neue Technologie, Plattform oder Service von seiner Vorstellung bis zu einer Marktdurchdringung von einer Million Nutzer gebraucht hat, so waren 1999 bei Netflix noch 3.5 Jahre nötig und bei ChatGPT vor einem Jahr gerade einmal 5 Stunden [^5]. Das drückt nicht nur aus, wie leistungsfähig und skalierbar Technologien heute sind, sondern zugleich welche Breite und Geschwindigkeit dieses Voranschreiten hat.

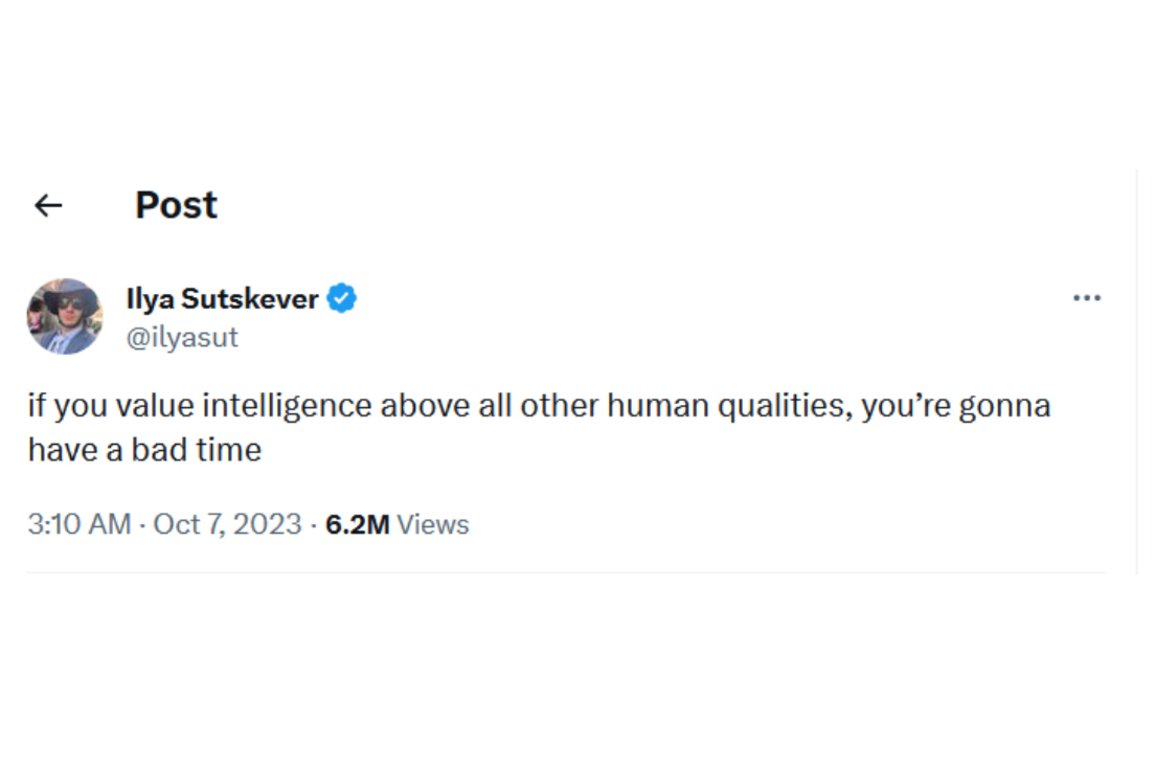

Derzeit bilden die großen Sprachmodelle die "Speerspitze" der KI und im Rennen um das leistungsfähigste Netz hat gerade Google mit der Vorstellung seines Gemini-Modells Anfang Dezember die nächste Runde eröffnet. Gemini ist ein Modell das erstaunliche, multimodale Fähigkeiten besitzt, also die Möglichkeit hat, übergreifend mit den verschiedensten Sinneseindrücken, wie Text, Sprache, Musik, Bild und Film umzugehen und in mehreren Benchmarks OpenAI's GPT-4 schlägt. Ob LLM's in der ein oder anderen abgewandelten, ergänzten Form den Weg zum heiligen Gral AGI ebnen werden ist umstritten und nicht zu beantworten. Sicher ist jedoch, dass vor uns neben vielen offenen Fragen zu Einsatz, Regulierung, Gestaltung des Zugangs und Ethik auch viele Überraschungen liegen, die wir noch nicht einmal ahnen. Nachdenklich stimmt in diesem Zusammenhang ein Tweet des oben schon erwähnten Chief-Scientist von OpenAI Ilya Sutskever, der einen Vorgeschmack auf die Zukunft gibt: [^8]:

Quellen

- [^1] @jburnmurdoch 10.11.2023

- [^2] Greg & Sam are BACK! (+ Q-Star is AGI) (Also Memes)

- [^3] A. Vaswani et. al., Attention Is All You Need, arXiv:1706.03762, Dez. 2017 [^4] Stable Diffusion Online

- [^5] Number of ChatGPT Users (Dec 2023)

- [^6] T. B. Brown u. a., „Language Models are Few-Shot Learners“. arXiv, 22. Juli 2020. doi: 10.48550/arXiv.2005.14165.

- [^7] H. Touvron, L. Mar tin, und K. Stone, „Llama 2: Open Foundation and Fine-Tuned Chat Models“, Meta AI Blog

- [^8] @ilyasut 07.10.2023

Blog von Prof. Dr. Janko Dietzsch

- Prof. Dr. Janko Dietzsch / Tel.: 0711/1849-4615 / E-Mail: janko.dietzsch@dhbw-stuttgart.de

![Linkes Bild mit Stabil Diffusion generiert [^4], Rechtes Bild entnommen [^3] Transformer Roboter und Schaubild](/fileadmin/_processed_/3/c/csm_2023-12-14_Zfki-Blog_ChatGPT_3_4_Autobots_TransformerArchitecture_0e86aa6e32.jpg)